Transportables VR-Equipment von njb design®

Verbindet Marketing und Technologie,

3D-Medien und Realität - njb design®

- Gründung 2008

- Joint-Venture für digitale Medien seit 2012

- standardisierte Prozesse

- modulare Workflows

- langfristiges Setup

Umfassendes Knowhow und langjährige Erfahrung

- Forschung im Bereich der 3D-Medien

- Evaluation von Anwendungen für Präsentations- und Marketingzwecke

- Implementierung neuer Entwicklungen in professionelle Workflows

- Design von Inhalten und Applikationen für sämtliche 3D-Medien

- Produktion von 3D-Animationen, interaktiven 3D-Präsentationen und Games

3D-Interaktiv

Medien: Desktop, Web, VR / AR Equipment, Mobile, Spielekonsolen

- virtuelle Interaktion mit Produkten

- interaktive Produktkonfiguration

- benutzergesteuerte Rundgänge

- Interaktion zwischen Benutzern via Web

- Präsentationsumgebung nach Mass

- komplett kundenspezifisches UI-Design

- beliebige Eingabegeräte

- Applikationen für Marketing, Verkauf, Schulung und Support

- Automatische Software Updates

- Plattformen: Windows, macOS, HTML5 / WebGL, Android, iOS

3D-Animation

Medien: Desktop, Web, TV

- Animation von Produktfunktionen und technischen Highlights

- Animation von Prozessabläufen

- beliebiges Ein- und Ausblenden von Komponenten

- Animation von Flüssigkeiten und Partikeleffekten

- nahtlose Kombination mit Filmmaterial

- Videoausgabe standardmässig in 4K oder 8K

- Grundlage für 3D-Interaktiv

3D-Visualisierung / Illustration

Medien: Desktop, Web, Druck

- einheitliche Präsentation von Produkten und Produktoptionen

- übersichtliche Darstellung und modulare Konfiguration grossflächiger Anlagen

- Visualisierung von Bauprojekten

- Illustration von Prozessen und Prozessabläufen

- Abstraktion komplexer Prozesse

- Schnitt- und Explosionsdarstellungen

- realistische Darstellungen während der Produktentwicklung

Flüssigkeits- und Partikelsysteme

Partikelsysteme kommen bei der Simulation von Flüssigkeiten und Gasen im virtuellen Raum zum Einsatz. Mit Emittern, den eigentlichen Quellen der Partikel, werden die gewünschten Partikelwolken generiert. Dies kann im freien Raum oder abhängig von Oberflächen oder innerhalb von definierten Volumen geschehen. Für jede Quelle werden Spawnrate (Geburtsrate), Lebensdauer, Geschwindigkeit, Dichte und Viskosität festgelegt. Effekte wie Turbulenzen, Gravitation und Wind können gezielt eingesetzt werden, um das Verhalten der Partikel nach der Generierung zu beeinflussen. Bei Flüssigkeiten werden abhängig vom Abstand polygonale Oberflächen zwischen den einzelnen Partikeln generiert. Je höher die Partikeldichte, desto genauer wird das Ergebnis.

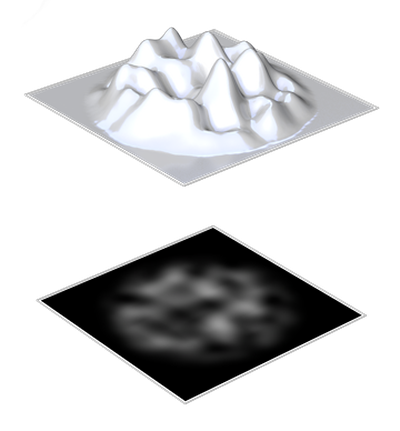

Umgebungserfassung

Panoramaaufnahmen oder einzelne Fotos eines Standortes, können im virtuellen Raum als Umgebung verwendet werden. In den meisten Fällen werden Panoramaaufnahmen aus verzerrungsfreien HDR-Einzelbildern erstellt, welche durch Stitching kombiniert und für die sphärische Projektion vorbereitet werden. Im virtuellen Raum werden die Panoramaaufnahmen anschliessend auf eine Kugelform projiziert, welche die jeweilige Szene umgibt. Inhalte einzelner Fotos können flexibel in einer Szene positioniert werden, um angrenzende Bereiche wiederzugeben.

3D-CAD

3D-Modelle welche bei der Planung und Konstruktion erstellt werden, können direkt für Visualisierungen und Animationen verwendet werden. Bei interaktiven Produktionen dienen die Modelle als Basis und werden entsprechend optimiert. Bei grösseren Baugruppen ist es sinnvoll, diese bereits vor dem Export auf die sichtbaren bzw. in den Prozess involvierten Teile zu reduzieren. Das optimale 3D-Format für den Export wird abhängig vom eingesetzten CAD-System festgelegt.

Objekte

Objekte werden abhängig von der Form, mittels manueller Vermessung und der anschliessenden Modellierung oder dem Einsatz eines Scanverfahrens in den virtuellen Raum überführt. Technische Formen werden dabei eher manuell Vermessen, während bei natürlichen und organischen Formen der Einsatz von Scannern sinnvoll ist.

2D-CAD

Technische Zeichnungen aus 2D-CAD Systemen sind bestens geeignet für die Erstellung von 3D-Modellen. Sämtliche Geometrien und Abmessungen können direkt in den 3D-Raum überführt werden.

Skizzen / Fotos

Skizzen dienen als erste Grundlage zur Visualisierung von Ideen und Konzepten. Zusammen mit Fotos ähnlicher Objekte oder Formen, bieten sie eine gute Basis zum Erstellen von 3D-Modellen. Während des Modellierens, können sämtliche Inputs berücksichtigt werden. Schritt für Schritt werden so die finalen Formen festgelegt. Es ist jederzeit möglich, anhand von Zwischenresultaten in 3D, die Formen weiter auszuarbeiten und so die Vorstellungen möglichst genau abzubilden.

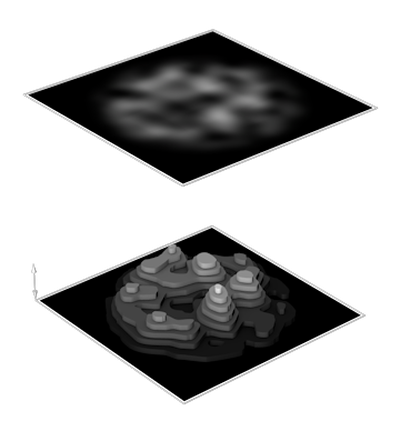

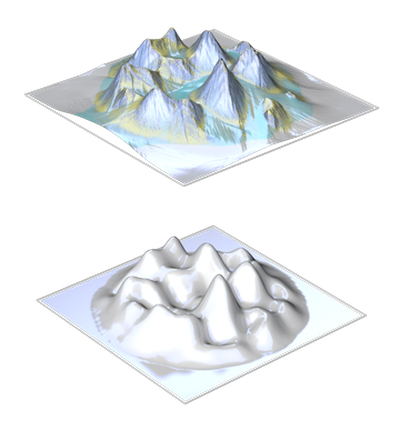

Graustufen Heightmaps

Eine Heightmap ist ein Graustufenrelief, bei welchem dunkle Bereiche tiefe-und helle Bereiche hohe Gebiete von Landschaften oder Oberflächen wiedergeben. Die Höhengenauigkeit ist dabei abhängig von der Farbtiefe des Bildes. Ein Graustufenbild mit 8-Bit Farbtiefe enthält 255, eines mit 16-Bit 65‘535 Höhenabstufungen. Die Auflösung bestimmt die Genauigkeit der Fläche. Ein Pixel ist dabei die kleinste darstellbare Länge, welche einem bestimmten Mass in der Realität entspricht. Heightmaps basierend auf Daten aus der Satellitenvermessung und Luftbildfotografie sind für die gesamte Erdoberfläche verfügbar.

3D-Scan

Für die Erstellung von 3D-Modellen realer Objekte, bieten sich neben der klassischen Modellierung auch verschiedene Scanverfahren an. Der Einsatz eines 3D-Scans ist insbesondere bei natürlichen und organischen Formen von Vorteil. Mittels Laser werden die Oberflächen in einem bestimmten Raster vermessen. Das Resultat ist eine Vielzahl von Messpunkten (Punktewolke), auf deren Basis anschliessend ein polygonales Modell erstellt wird. Eine einfache Alternative zur Laservermessung bietet die Fotogrammmetrie. Die Objekte werden dabei mit einem speziellen Beleuchtungssetup aus verschiedenen Winkeln fotografiert. Anschliessend wird anhand von übereinstimmenden Bildpunkten auf den verschiedenen Aufnahmen das 3D-Modell berechnet. Die aufgenommenen Fotodaten können dabei zudem zur Materialisierung der 3D-Modelle verwendet werden.

Modellierung

Auf Basis der vorhandenen Daten werden die 3D-Modelle erstellt. Bei der Modellierung kommen die verschiedensten Werkzeuge zum Einsatz, vergleichbar mit Fertigungsmethoden in der Realität. Jede Fläche eines 3D-Modells ist durch drei Punkte definiert und wird Polygon genannt. Eine rechteckige Fläche besteht somit aus zwei Polygonen. Je genauer eine Form wiedergegeben werden soll, desto mehr Polygone / Unterteilungen sind dazu erforderlich. Rechteckige, Kreisförmige und auf Splines basierte Formen sind weitgehend automatisiert. Bei Freiformen kann jeder Punkt einer Oberfläche einzeln definiert werden. Dies geschieht meist mit wenigen Unterteilungen, also kleiner Polygonzahl. Das Modell wird anschliessend auf die gewünschte Qualität hochgerechnet. Dabei wird jede Fläche automatisch weiter Unterteilt. Zudem kommen Deformer zum Einsatz, welche es erlauben Modelle an bestimmten Stellen zu deformieren (biegen, stauchen, expandieren usw.).

Heightmap Generierung

Beim Erstellen von Heightmaps werden vorhandene Höhendaten in Grauwerte umgewandelt oder komplett neue Landschaften erstellt. Dabei kommen Programme zum Einsatz, welche die Grauwerte der Heightmaps direkt als 3D-Modell visualisieren. Durch die Verwendung von verschiedenen Rauschfunktionen (Noise) und manuellen Anpassungen, können so realitätsnahe Landschaftsformen erstellt werden.

Referenzieren / Gruppieren

Baugruppen aus dem technischen Bereich sind meist der Montage oder Funktion entsprechend gruppiert. Für 3D-Animationen und 3D-Interaktiv wird nun geprüft ob sämtliche Bewegungen mit der vorhandenen Struktur ausgeführt werden können. Bei Bedarf werden weitere Bewegungsgruppen erstellt. In einem zweiten Schritt werden die Einzelteile pro Baugruppe dem Material entsprechend sortiert. Bestehende Materialzuordnungen werden nach Möglichkeit übernommen. Mehrfach verwendete Baugruppen werden nur einmal optimiert und als Instanzen an den verschiedenen Positionen referenziert.

Motion Capture

Das Erfassen von Bewegungen in der Realität und die anschliessende Wiedergabe im virtuellen Raum, erzeugen äusserst natürliche Ergebnisse. Die Positionen verschiedener Referenzpunkte an Objekten, werden dazu während dem Ausführen von Bewegungen fortlaufend aufgezeichnet. Die aufgezeichneten Bewegungen können danach im virtuellen Raum direkt auf ein Skelett übertragen werden, welches der realen Struktur entspricht.

Storyboard

Vor der Umsetzung eines Projekts werden mit dem Storyboard sämtliche Vorgaben aufgenommen. Ausgehend von der Kernaussage der jeweiligen Szene, werden Kameraeinstellungen, Perspektiven, Bewegungsabläufe, Materialisierung, Beleuchtung, Länge, Audio und die Umgebung abgeleitet. Bei 3D-Interaktiv enthält das Storyboard zudem die Definition sämtlicher Interaktionen und die Spezifikation des Bewegungskonzepts.

Rigging

Bei Animationen, welche die Modellform auf polygonaler Ebene verändern, werden die einzelnen Punkte eines 3D-Modells einem Skelett zugewiesen. Eine Komposition von Skelett und 3D-Modell wird Charakter genannt. Dabei repräsentiert ein Skelett wie in der Realität die tragende Struktur eines Objekts und besteht aus Knochen (Bones) und Gelenken (Joints). Die Oberfläche eines 3D-Modells kann dabei mit der Haut verglichen werden. Anstelle der aufwendigen Animation einzelner Modellpunkte, werden die Knochen und Gelenke animiert, während die Oberfläche automatisch den zugewiesenen Knochen folgt. Einzelne Modellpunkte können unter dem Einfluss mehrerer Knochen stehen. Ein Oberflächenpunkt nahe einem Gelenk, kann beispielsweise zu 40% dem Knochen vor und zu 60% dem Knochen nach dem Gelenk folgen. Sämtliche Zuweisungen werden in einer Weightingtable auch Vertexmap genannt, hinterlegt. Für jedes Gelenk können Constraints definiert werden, welche das Einschränken des Bewegungsraums oder die Definition von Abhängigkeiten zu anderen Gelenken ermöglichen. Dies ermöglicht auch die Erstellung inverser Kinematik-Systeme zur Berechnung mehrerer aneinandergereihter Knochen in entgegengesetzter Richtung. Zum Beispiel, um automatisch die Bewegung aller Knochen bis zur Schulter zu berechnen, während eine Hand bewegt wird.

Produktionsdaten

Für die Herstellung von Objekten mittels 3D-Druck oder spanabhebenden Verfahren werden die 3D-Modelle optimiert und die gewünschten Fertigungsdaten in beliebigem Massstab abgeleitet. Die Optimierung der 3D-Modelle kann das Verschmelzen von einzelnen 3D-Teilen, die Reduzierung von Details oder das Verbessern von Kanten beinhalten. Die Fertigungsdaten umfassen 3D-Modelle wie auch technische Zeichnungen oder 2D-Konturen für die Laserbearbeitung und Gravuren.

Animation / Simulation

Bei der Animation werden sämtliche Parameter entlang der Zeitachse festgelegt. Mit der klassischen Key-Animation werden Position, Ausrichtung, Skalierung oder andere Eigenschaften von Objekten, Key für Key definiert. Zur Erstellung der gewünschten Animationskurven stehen verschiedene Interpolationsmethoden zur Verfügung. Diese erlauben die Anpassung von Beschleunigungswerten vor und nach einem Key und somit die Erstellung von harten und weichen Übergängen. Durch die Definition von Bedingungen, z.B. die Ausrichtung von Objekten zu anderen oder die Positionierung von Objekten entlang von Pfaden oder auf Oberflächen, wird die klassische Animation ergänzt. Sofern die Aktivierung von Animationssequenzen abhängig von Benutzereingaben oder anderen Ereignissen erfolgt, können die Abhängigkeiten entsprechend programmiert werden. Das Abspielen der jeweiligen Animation kann danach zu jedem Zeitpunkt erfolgen und ist nicht mehr an eine bestimmte Position in der Zeitachse gebunden. Bei der physikalischen Simulation von Kräften in Echtzeit, beispielsweise der Gravitation, ist die klassische Animation nicht erforderlich. Die Position der Objekte wird dabei abhängig von im Voraus definierten Simulationswerten wie Gewicht, Reibung, usw. automatisch berechnet.

Unternehmensstandards

Durch das Corporate Design festgelegte grafische Vorgaben werden während des gesamten Prozesses berücksichtigt. njb design® unterstützt Kunden zudem bei der Implementierung und Definition von Standards für 3D-Medien. Farben und Logos können jederzeit auf dem neusten Stand gehalten werden. Neue Inhalte und Weiterentwicklungen werden so implementiert, dass sie mit bestehendem Material kompatibel sind.

Umgebung

Die Umgebung einer Szene hat wesentlichen Einfluss auf das Aussehen einer Visualisierung. Umgebungen können Materialeigenschaften wie Reflektionen beeinflussen und als Skylights für die globale Ausleuchtung einer Szene verwendet oder als reine Hintergrundelemente dargestellt werden, welche den Inhalt einer Szene nicht beeinflussen. Für die Darstellung von HDR-Panoramaaufnahmen oder parametrischen Sky-Shader, welche Umgebungen basierend auf Datum, Uhrzeit und Wetter generieren, kommen Sphären zum Einsatz, welche die gesamte Szene umgeben. Abgesehen von globalen Umgebungen kann jedes 3D-Objekt in einer Szene als Umgebungselement verwendet werden, um die Materialeigenschaften oder die Beleuchtung gezielt zu beeinflussen.

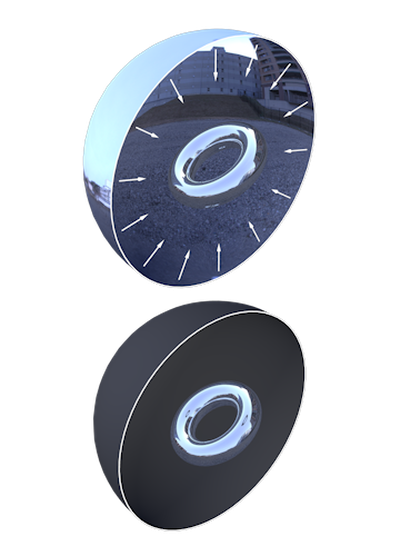

Oberflächen Scan / Foto

Die Erfassung von Oberflächen zur Erstellung virtueller Materialen erfolgt meist fotografisch. Dabei ist die gleichmässige Ausleuchtung der Oberflächen zur Minimierung von Schattierungen und Reflexionen entscheidend. Neben der Aufnahme von Farbwerten können Oberflächen mittels Fotogrammmetrie oder anderen Scanverfahren auch in 3D erfasst werden. Das resultierende 3D-Modell kann direkt eingesetzt oder für die Erstellung von Bump- und Normalmaps verwendet werden.

Parametrische Shader

Im Gegensatz zu Materialien, welche auf Fotodaten basieren, werden parametrische Shader für jede Position auf einer Oberfläche mittels mathematischer Funktionen (procedural) berechnet und sind daher nicht an eine feste Pixelauflösung gebunden. Bei der Berechnung kommen Rauschfunktionen (Noise) wie Perlin, Simplex oder Voronoi zum Einsatz, welche basierend auf einem Startwert (Seed) die entsprechenden Muster generieren. Mittels globaler Parameter lassen sich Werte wie Skalierung oder Genauigkeit der Berechnung kontrollieren.

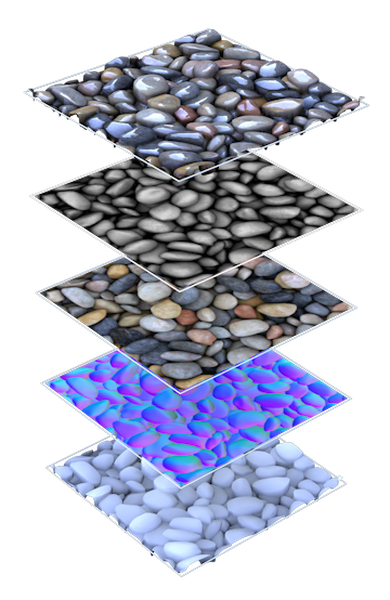

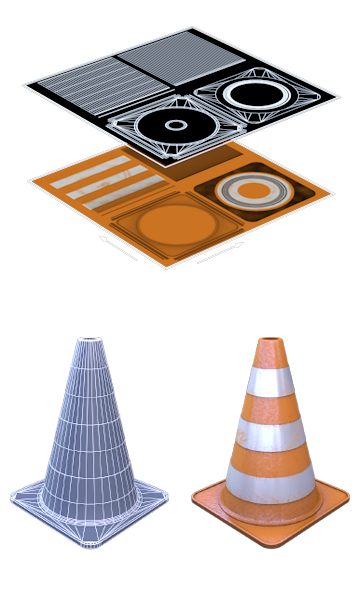

Texturaufbereitung

Eine Textur ist meist ein quadratisches Bild, bei welchem die gegenüberliegenden Seiten kompatibel sind. Durch die Kombination verschiedener Foto-Ausschnitte einer Oberfläche, werden kachelbare Texturen generiert, welche anschiessend als endlose Muster auf 3D-Modelle projiziert werden können. Sofern neben den Farbwerten auch 3D-Daten erfasst wurden, werden diese zur Erstellung von Bump- und Normalmaps verwendet, welche als Bestandteil der kachelbaren Texturen zum Einsatz kommen. Für 3D-Interaktiv, können verschiedene Oberflächentypen in einer Texturdatei zusammengefasst werden, um die Anzahl Texturen und damit den Speicherbedarf zu reduzieren. Solche Texturen sind nicht kachelbar und werden spezifisch pro UV-Map eines 3D-Modells erstellt.

Materialisierung

Ein Material (Shader) besteht aus verschiedenen Kanälen, welche die optischen Eigenschaften einer Oberfläche definieren. Dazu gehören Farbe (Diffusion), Glanzlicht, Reflektion, Transparenz und Brechung, verschiedene Verfahren zur Darstellung von Verformungen, die Maskierung und Leuchten (Emissive). Jeder Kanal kann einzeln und für jede Position auf der Oberfläche angepasst werden. Verformungen können durch die Projektion von Schattierungen auf die Oberfläche (Relief/Normal) oder mittels Parallaxe simuliert werden. Daneben ist es auch möglich mittels Displacement die Polygone eines 3D-Modells direkt auf Basis einer Bumpmap zu verformen. Materialien können kompletten Baugruppen, Einzelteilen oder einzelnen Polygonflächen zugewiesen werden. Bei 3D-Modellen mit UV-Map kann direkt auf der Modelloberfläche und allen verfügbaren Kanälen gezeichnet werden. Schatten und andere Lichteffekte können vorgerendert und als Lightmaps auf die Modelloberflächen projiziert werden (backing). Bei der physikalischen Simulation werden neben optischen Eigenschaften, auch Werte für Dichte, Reibung und Elastizität der Oberflächen, definiert.

Beleuchtung

Die Ausleuchtung einer Szene ist abhängig vom Hauptmotiv und der jeweiligen Ansichtsrichtung. Ein klassisches Setup beinhaltet ein Führungslicht als Grundbeleuchtung, Aufheller zur Erweiterung der Grundbeleuchtung und Effektlichter zur Hervorhebung von Kanten oder bestimmten Bereichen. Für jede Lichtquelle können individuell Intensität, Farbe, Form und Schattenwurf festgelegt werden. Dabei kommen Punktlichter, welche in alle Richtungen Licht abstrahlen, Spotlichter, welche einen Lichtkegel bilden oder Flächenlichter, welche basierend auf einer Objektform Licht abstrahlen, zum Einsatz. Mit IES-Lichtprofilen ist es möglich die Form realer Leuchtmittel wiederzugeben. Licht kann im virtuellen Raum mit Hilfe volumetrischer Lichter sichtbar gemacht werden. Neben individuellen Lichtquellen können auch globale Skylights eingesetzt werden (siehe Umgebung).

Rendering

Beim Rendering werden 3D-Modelle, Materialien und Lichteigenschaften für die finale Bildausgabe berechnet. Ausgehend von sämtlichen Lichtquellen wird mittels Ray-Tracing die Beleuchtung für die jeweilige Szene abgeleitet. Durch den Einsatz von Global Illumination können Lichtstrahlen nach dem Auftreffen auf Oberflächen, mehrfach weiterverfolgt werden. Dabei wird abhängig von den Oberflächeneigenschaften und dem Einfallswinkel eine bestimmte Lichtmenge weitergeleitet. Mit verschiedenen Effekten lässt sich das Ergebnis gezielt beeinflussen. Mit Ambient Occlusion lassen sich beispielsweise abhängig vom Winkel und der Distanz zwischen Flächen, automatisch Schattierungen erzeugen. Daneben sind Verfahren im Einsatz, welche die Überführung der Resultate in der Pixelraum und das Abspielen von Einzelbildern als Animationen optimieren (Antialiasing, Motion-Blur). Die Dauer der Bildberechnung ist abhängig von der finalen Pixelauflösung, der Genauigkeit und Tiefe der Lichtberechnung, Komplexität der Modelle und Materialien, und der eingesetzten Effekte. Für jedes Objekt in einer Szene kann die Berechnungsdauer, beispielsweise abhängig von der Entfernung zur Kamera, optimiert werden.

Kompilierung

Durch das Kompilieren werden sämtliche Funktionen und Inhalte eines Projekts, abhängig von der verwendeten Engine bzw. Programmiersprache, in ausführbare Programme umgewandelt. Anwendungen können für verschiedene Plattformen wie Windows, macOS, Android und iOS generiert werden. Interaktive Onlineanwendungen können als HTML5-/ WebGL-Projekte ausgegeben werden.

Grafische Bearbeitung

Bei der grafischen Bearbeitung werden die Renderings der Verwendung entsprechend aufbereitet und die gewünschten Bildformate exportiert. Renderings mit einer Farbtiefe von 32-bit (HDR), erlauben bei der Umwandlung in 8-bit Druckformate die gezielte Optimierung von Kontrast, Helligkeit und Farbwerten. Mittels Licht- und Effektkanälen kann nachträglich die Intensität einzelner Lichtquellen und von Effekten bearbeitet werden. Einzelne Objekte einer Szene lassen sich auf separaten Ebenen halten und durch Maskierung mit transparentem Hintergrund darstellen. Bei der Kombination von 3D-Objekten mit Fotos, kann der Schattenwurf von Objekten in die Fotoumgebung integriert werden.

Audio / Video

Sämtliche Audio- und Videodaten können zur Ergänzung von 3D-Animationen und 3D-Interaktiv eingesetzt werden. Hintergrundmusik unterstützt den Ablauf einer Animation und kann die Taktung von Bewegungen oder des Videoschnitts vorgeben. Sprachaufnahmen werden zur auditiven Information oder bei Dialogen eingesetzt. Bei 3D-Interaktiv kann das Abspielen von Video- und Audiosequenzen abhängig von Benutzeraktionen-, Eingaben, oder bestimmten Werten erfolgen. Videomaterial kann nahtlos mit 3D-Inhalten kombiniert und erweitert werden.

Videobearbeitung

Bei der Videobearbeitung erfolgt die finale Komposition von Video-, Bild- und Audiomaterial. Die einzelnen Szenen werden aufbereitet und beim Videoschnitt optimal aufeinander abgestimmt. Vektorgrafiken wie Logos und Texteinblendungen werden gemäss grafischen Vorgaben eingesetzt. Mit Motion-Tracking lassen sich Elemente fortlaufend am Bildinhalt ausrichten. Für Übergänge zwischen Szenen und verschiedenen Medien, stehen eine Vielzahl von Effekten und Blenden zur Verfügung. Bei der Synchronisation wird das Video- und Audiomaterial aufeinander abgestimmt.

Encoding

Basierend auf der finalen Komposition werden die gewünschten Videoformate abgeleitet. Das Videoformat, die Komprimierung, Auflösung und Bildrate werden abhängig vom späteren Verwendungszweck festgelegt. Die Ausgabe kann mit verschiedenen Profilen bis 8K (7680x4360 Pixel) bei 60bps erfolgen. Ein verbreitetes Videoformat ist MP4 mit H.264 Komprimierung.

3D-Visualisierung / Illustration

Hochauflösende Einzelbilder für Desktop, Web und Druck.

3D-Animation

Videopräsentationen für Web, Desktop und TV.

3D-Interaktiv

Interaktive Applikationen für Desktop, Web, VR- / AR- Equipment, Mobile und Spielekonsolen.

Erosionssimulation

Heightmaps können verschiedenen Formen von Erosion ausgesetzt werden. Dies umfasst die auf Flüssigkeit basierende Flusserosion welche Kanäle und Täler bildet, die äolische Erosion, welche durch im Wind enthaltene Partikeln das Gestein abträgt und die küstennahe Erosion welche durch die Brandung von Meeren entsteht. Verschiedene Faktoren wie Dauer der Erosion, Härte des Gesteins und Dichte des abgetragenen Materials werden in der Simulation berücksichtigt. Neben der Ausgabe von erodierten Heightmaps, können zusätzlich auch Masken für die anschliessende Texturierung der Landschaft erstellt werden, welche die einzelnen Oberflächen wie Erosionskanäle, Fels, Schutt usw. wiedergeben.

Inszenierung

Gemäss Storyboard, Layouts und Unternehmensstandards werden pro Szene sämtliche Objekte und Kameras positioniert und die Perspektiven eingestellt. Virtuelle Kameras verfügen dabei über Einstellungsmöglichkeiten, welche mit denen von Kameras in der Realität vergleichbar sind (Brennweite, Blende usw.). Darüber hinaus können die Sensorformate frei bestimmt und sämtliche Kameraeinstellungen animiert werden. Bei animierten Kameraflügen werden, wie bei der Animation von Objekten, die Positionen der Kameras entlang der Zeitachse festgelegt.

Oberflächenabwicklung

Um Materialien auf der Oberfläche von 3D-Modellen darzustellen, werden Oberflächenabwicklungen im 2D-Raum erstellt. Eine Abwicklung eines 3D-Modells wird UV-Map genannt, wobei die Buchstaben U und V die Bezeichnungen der 2D-Achsen sind. Bei gewölbten Freiformflächen, welche ohne Auftrennungen nicht im 2D-Raum dargestellt werden können, wird eine gewisse Verzerrung in Kauf genommen. Damit wird die Kontinuität der Flächen im 2D-Raum erhalten und die unterbrechungsfreie Projektion der Materialien sichergestellt. Bei 3D-Modellen mit verschiedenen Materialzuweisungen, können die UV-Maps pro Material bearbeitet werden. Neben dem UV-Mapping sind vereinfachte Verfahren verfügbar, bei welchen die Projektion unabhängig von der Objektform erfolgt. Die Materialien können dabei ausgehend von einer 2D-Fläche, Kugel-, Würfel- oder Zylinderform auf die Modelloberflächen projiziert werden.

UI / Programmierung

Bei 3D-Interaktiv und Games können Benutzeraktionen- und Eingaben, bestimmten Funktionen innerhalb eines Projekts zugewiesen werden. Die Auslösung von Funktionen kann abhängig von Werten, beispielsweise der Position eines Benutzers im virtuellen Raum oder durch beliebige Eingabegeräte erfolgen (Touchscreen, Maus, Tastatur, Gamepad, VR / AR Equipment, usw.). Mit UI-Elementen wie Buttons, Eingabefeldern, Checkboxes, usw. lassen sich Einstellungen vornehmen und Benutzerdialoge verarbeiten. Variablen können in regelmässigen Abständen oder bei definierten Ereignissen lokal oder mittels Datenbankanbindung in der Cloud gespeichert oder abgerufen werden.